ControlNet を使ってざっくり手描きした絵から期待する画像をつくる

https://github.com/lllyasviel/ControlNet を使ってみました。 ControlNet はいくつかの機能があるのですが、その中の手描き画像+プロンプトから画像を生成するものを試しました。

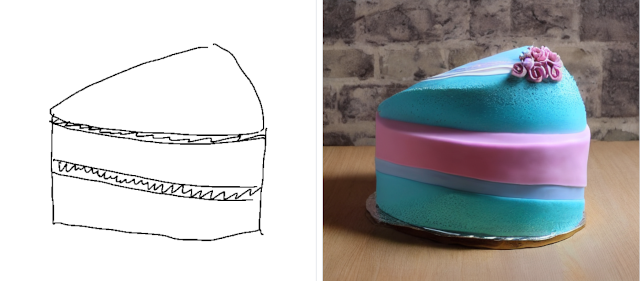

ケーキ

Prompt: cake

cake だけプロンプト指定した結果です。あまり美味しそうではない。 いやしかし、コントロールはできている。手描きのケーキにそった絵ができている。すごい。

ちなみに、 a piece of cake と書いてみたけど cake とだけ書いた場合とほとんど同じでした。

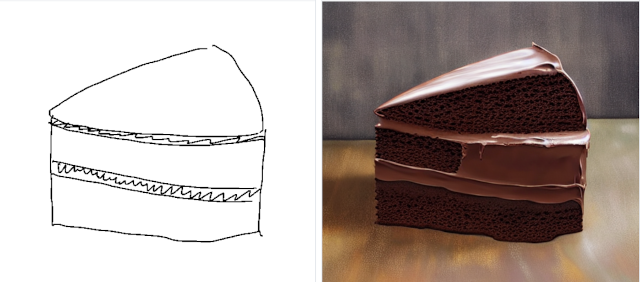

Prompt: chocolate cake

chocolate を足すと美味しい感じのケーキができました。

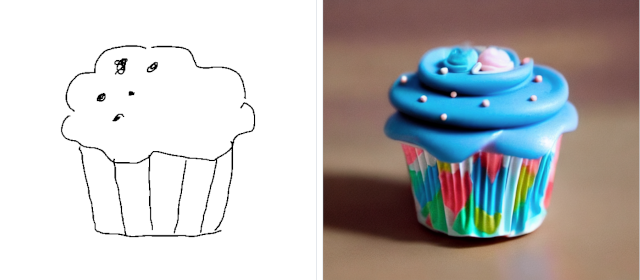

カップケーキ

Prompt: cupcake

また青ベースになりました。ケーキといえば青なのだろうか。 ただ間違いなくカップケーキでありアンダーコントロールです。

Prompt: chocolate cupcake

これは美味しそう。

机

Prompt: desk

プレーンな机を期待したのですが、いろいろ盛った感じの画像が出現しました。 AIの心遣いなのか。

Prompt: simple wooden ikea desk (とかそんな感じのプロンプトを入れたと記憶している、が定かではない)

期待したイメージに近づきました。ノートパソコンが出現。

Prompt: simple ikea pine desk

パイン材の机を描いてくれました。ありがとう。 期待したイメージとほぼ同じです。 しかし、手描きのいびつさまで反映されてしまった。 実写になったのだから、そこは逆に気を利かせて補正してくれればいいのに。 (それをプロンプトで指示しろ、という話かな。)

まとめ

まずは単一オブジェクトであれば、 簡単なプロンプトで(そこまで期待しなければ、十分に)意図した画像ができることがわかりました。 もちろん、コントロールネットの秘めた力こんなもんじゃないのかもしれません。

自分でトレーニングする方法の解説もあったので、可能ならやってみたい。 ただ、手持ちのGPUでトレーニングするには性能があまりに不足な気もする。

Liked some of this entry? Buy me a coffee, please.